Устойчивость и помехозащищенность

В рассмотренном в разд. 1.1 примере относительно жесткого закрепления нейронов выходного слоя между образами принцип ассоциативности или ответ на вопрос: «На что более всего это похоже?», пока не просматривается. Как же он появляется?

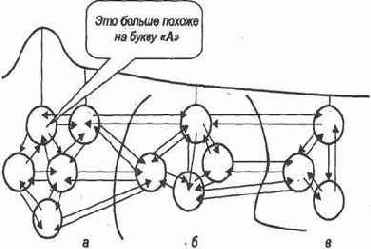

Представим себе выходной слой нейросети (рис. 1.5). Рассматривая прохождение возбуждения, например, при подаче того же изображения буквы А, считаем, что в возбужденное состояние придет не один нейрон, строго соответствующий (по нашему желанию) этой букве, — в его окрестности возбудятся и другие нейроны. Причем возбуждение будет угасать по мере удаления. Нам же необходимо, чтобы максимальной величиной возбуждения в этой окрестности обладал именно отмеченный нейрон. Более того, желательно, чтобы эта величина возбуждения была существенно выше величин возбуждения других нейронов. Это обеспечит однозначность при последующем использовании полученного вывода в построении «длинных» логических цепочек для принятия решения. Такая локализация возбуждения позволяет с большой определенностью ответить на вопрос: «На что более всего похож предъявляемый образ, несмотря на случайные отличия его от эталона и помехи?»

Отметим существующую в природе (реализованную в мозге) непрерывность перерастания свойства похожести одних образов в другие. Следование этому принципу при принудительном закреплении нейронов выходного слоя способствует построению адекватных моделей. Говоря точнее, подавая первый раз букву А при случайном начальном выборе весов, не следует указывать системе, какой нейрон выходного слоя должен возбудиться. Лучше подать достаточно «правильный» эталон и посмотреть, какой нейрон возбудится. Этот нейрон и будет впредь соответствовать нашей букве. Возбуждения именно этого нейрона необходимо добиваться при предъявлении других эталонов.

Далее при построении алгоритма обучения предположим, что первоначально сеть «пуста», т.е. все веса синапсических связей равны нулю. Путь возбуждения (связь «посылка — следствие») прокладывается («трассируется») с помощью присваивания некоторым весам положительного значения.

Способы максимизации и локализации уровня возбуждения основаны на нахождении экстремума функции возбуждения, построенной в области выходного слоя. Здесь не обойтись без обмена тормозящими воздействиями между нейронами выходного слоя. Суть идеи в следующем. Все нейроны выходного слоя имеют синапсические связи, такие, что каждый нейрон связан с ближайшими нейронами тормозящими связями, по модулю пропорциональными величине собственного возбуждения. В результате взаимодействия двух нейронов (один из алгоритмов такого взаимодействия будет рассмотрен ниже) более «сильный» сохранит положительный (хотя и меньший) потенциал, сообщив более «слабому» тормозящее воздействие. Такое пошаговое «голосование» на фоне приходящего подтверждения от эталона и выделит сильнейшего.

Итак, мы видим, что обучение сети неразрывно связано с локализацией возбуждения на выходном слое.